Künstliche Intelligenz (KI) hat sich innerhalb kurzer Zeit zu einem festen Bestandteil unseres Alltags entwickelt. In der Industrie gilt sie längst als Schlüsseltechnologie der Zukunft. Doch mit den Fortschritten der KI und ihrer zunehmenden Leistungsfähigkeit gewinnt zwangsläufig auch die Frage an Bedeutung, wie verlässlich diese Technologie ist: Können Entscheidungen, die von KI-Systemen getroffen werden, als sicher gelten?

Ein interdisziplinäres Forschungsteam der Technischen Universität (TU) Wien hat jetzt eine Methode entwickelt, mit der sich exakt berechnen lässt, wie sicher ein neuronales Netzwerk in einem definierten Inputbereich arbeitet. Das bedeutet konkret: Es lässt sich mathematisch garantieren, dass bestimmte Fehler nicht vorkommen. Das kann einen entscheidenden Schritt für den sicheren Einsatz von KI in sensiblen Bereichen bedeuten, wie Experten kommentieren.

Gerade wenn es um Sicherheit geht, ist die zentrale Frage entscheidend, ob ein KI-System garantiert keine schwerwiegenden Fehler macht, auch wenn der Input leicht variiert. Das Forschungsteam der TU Wien aus den Fachbereichen Informatik, Statistik und Mathematik hat nun einen Weg gefunden, neuronale Netzwerke so zu analysieren, dass sich für definierte Eingabebereiche exakt berechnen lässt, in welchem Wertebereich die Ausgaben liegen werden – und welche Fehler garantiert ausgeschlossen sind. So soll die Unsicherheit in Künstlicher Intelligenz kalkulierbar werden.

Unsicherheit bei der Eingabe = Unsicherheit bei der Ausgabe

„Neuronale Netze verhalten sich normalerweise vorhersehbar – sie geben jedes Mal die gleiche Ausgabe, wenn man den gleichen Input eingibt“, erklärt Dr. Andrey Kofnov aus dem Forscherteam der TU Wien. Doch in der realen Welt sind die Eingaben, die die KI erhält, oft verrauscht oder unsicher und können nicht immer durch einen einzigen, festen Wert beschrieben werden. „Diese Unsicherheit bei der Eingabe führt zu Unsicherheit bei der Ausgabe“, verdeutlicht der Wissenschaftler das Problem.

Sein Kollege Prof. Ezio Bartocci veranschaulicht dies an einem Beispiel: Ein neuronales Netz bekommt ein Bild als Input, das ein Tier zeigt. „Was passiert, wenn das Bild leicht verändert ist, etwa wegen einer anderen Kamera, etwas mehr Rauschen, veränderter Lichtverhältnisse etc.? Kann das dazu führen, dass die KI plötzlich etwas völlig anderes erkennt?“, fragt Professor Bartocci.

Solche Abweichungen können insbesondere in sicherheitskritischen Bereichen, wie etwa im Gesundheitswesen, im Verkehr oder im Ingenieurwesen, fatale Folgen haben, wie das VDI-Portal Ingenieur.de feststellt. Problematisch dabei ist, dass klassische neuronale Netze keine Auskunft darüber geben, wie sicher sie sich bei ihrer Entscheidung sind. Genau hier setzten die Forscher der TU Wien an.

Rechnen statt raten

Das volle Spektrum möglicher Ergebnisse zu verstehen, helfe dabei, bessere und sicherere Entscheidungen zu treffen, betonen die Wissenschaftler. Dies gelte insbesondere für Bereiche, in denen viel auf dem Spiel steht, wie im Finanzwesen, im Gesundheitswesen oder im Ingenieurwesen, hebt Dr. Kofnov hervor. „Indem wir die Wahrscheinlichkeit möglicher Ergebnisse berechnen, können wir wichtige Fragen beantworten“, erklärt der Experte: Etwa, wie hoch die Wahrscheinlichkeit eines extremen Ergebnisses oder ein Risiko ist.

Solche Fragen seien mit herkömmlichen Tests schwer zu beantworten, betont die TU Wien. Zwar kann man viele Fälle durchprobieren – doch eine vollständige Absicherung ist demnach praktisch unmöglich. Denn es kann immer noch Spezialfälle geben, die nicht getestet wurden, und bei denen das System versagt. Deshalb gaben die Wiener Forscher für ihre Arbeit die Parole aus: Rechnen statt raten! Üblicherweise analysierten Forschende das Verhalten neuronaler Netze mithilfe von Simulationen, berichtet Ingenieur.de. Dazu speisen die Wissenschaftler Millionen zufälliger Eingaben in das System und werten die Ergebnisse statistisch aus. Das ist aufwendig und liefert nur Näherungen, ohne Gewähr, dass extreme Ausreißer ausgeschlossen sind, so das Fachportal.

Geometrischer Ansatz

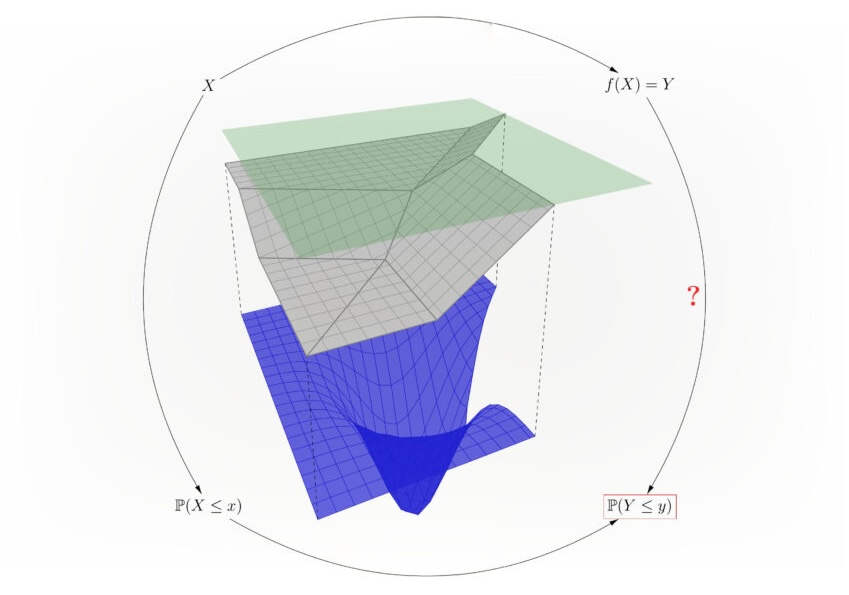

Das Forschungsteam der TU Wien wählte deshalb einen anderen, einen geometrischen Ansatz. Wie das funktioniert, erklärt Prof. Efstathia Bura vom Institut für Stochastik und Wirtschaftsmathematik der TU Wien. Hierbei wird die Menge aller möglichen Inputs, wie etwa alle möglichen Bilder, die man einem KI-System eingeben kann, in kleine Teilbereiche zerlegt. Dies geschieht ähnlich unserer dreidimensionalen Welt, aber mit einer beliebigen Zahl von Dimensionen, so Professor Bura. „Wir zerlegen diesen Raum in kleine Teilbereiche, für die sich jeweils exakt bestimmen lässt, welche Ausgaben das neuronale Netz generiert“, erläutert sie. Dadurch soll sich mathematisch die Wahrscheinlichkeit für unterschiedliche Ergebnis-Bereiche ermitteln lassen, sodass bestimmte Fehler mit 100-prozentiger Sicherheit ausgeschlossen werden können.

Für Fachleute geht Ingenieur.de noch mehr ins Detail: Die Methode verwendet sogenannte ReLU-Netze – neuronale Netze mit speziellen Aktivierungsfunktionen, berichtet das Fachportal. Diese lassen sich durch zwei Näherungsnetze beschreiben: eines, das das Verhalten von oben, und eines, das es von unten eingrenzt. In Kombination mit einer Wahrscheinlichkeitsverteilung der Eingabedaten, etwa einer Gaußverteilung, entstehe so ein klar definierter Wertebereich für die Ausgaben, heißt es weiter. Auf diese Weise lasse sich quantifizieren, wie hoch die Wahrscheinlichkeit für bestimmte Fehler oder Extreme ist.

Ein Meilenstein für vertrauenswürdige KI?

Der Ansatz der TU Wien sei ein wirklich spannender Meilenstein in der Entwicklung vertrauenswürdiger KI-Systeme, meint Prof. Dr. Marco Barenkamp, Gründer der auf KI-Entwicklungen spezialisierten Osnabrücker LMIS AG. „Denn in der industriellen Praxis beobachten wir seit Jahren, wie groß der Bedarf an verlässlichen, erklärbaren und absicherbaren KI-Lösungen ist – gerade in sicherheitskritischen Anwendungen und vor dem Hintergrund des rechtssicheren Einsatzes von KI im Rahmendes AI-Acts“, erklärt der Experte.

Er hält den Ansatz der Wiener Forscher auch deshalb für so spannend, weil er sich „nicht auf Wahrscheinlichkeitsaussagen stützt, sondern auf mathematische Garantien“. Das eröffne völlig neue Perspektiven, wenn man dieses Konzept weiterdenke, betont Professor Barenkamp – etwa im Hinblick auf die Zertifizierbarkeit KI-gestützter Systeme nach internationalen Sicherheitsnormen. „Dieser Ansatz, mit dem Ausgaben für einen klar umrissenen Input-Bereich garantiert werden können, ist in dem Kontext ein wirklich starkes Argument gegenüber Prüfinstitutionen und Aufsichtsbehörden“, stellt der Wirtschaftsinformatiker fest.

Für große KI noch nicht geeignet

Wie die TU Wien einräumt, ist dieser Ansatz allerdings noch nicht auf große neuronale Netze, wie etwa Large Language Models, anwendbar. „Eine KI wie ChatGPT ist viel zu komplex für diese Methode“, sagt Forschungsteammitglied Dr. Daniel Kapla. Sie zu analysieren, würde eine unvorstellbare Menge an Rechenleistung erfordern, weiß er. „Aber wir haben gezeigt, dass zumindest für kleine neuronale Netze eine rigorose Fehlerquantifizierung möglich ist“, unterstreichen die Forschenden.

Die TU Wien-Methode könne damit die Grundlage für sicherere KI-Anwendungen legen, resümiert Ingenieur.de, insbesondere in Bereichen, in denen es auf Verlässlichkeit ankommt. Dazu zählen die Experten unter anderem Diagnosesysteme in der Medizintechnik, Steuerungen in der Robotik und Luftfahrt, Sensorfusion in autonomen Fahrzeugen und Risikobewertungen in der Finanzbranche.

Und dass dieses Konzept für große Netze und komplexe Systeme noch nicht skalierbar einsetzbar sei, hält Prof. Barenkamp letztlich nicht für entscheidend. „Im Gegenteil, diese Methode ist ein starker Beleg dafür, dass sich Künstliche Intelligenz und formale Verifikation nicht ausschließen müssen, sondern dass wir als Branche gerade lernen, beide Welten zusammenzubringen“, ordnet er die Bedeutung der Wiener Forschungsergebnisse ein.

- https://www.tuwien.at/tu-wien/aktuelles/news/news/tu-wien-macht-unsicherheit-in-kuenstlicher-intelligenz-berechenbar

- https://www.ingenieur.de/technik/fachbereiche/kuenstliche-intelligenz/wie-verlaesslich-ist-ki-tu-wien-macht-unsicherheit-berechenbar/

- https://arxiv.org/abs/2502.11672

Titelbild-Illustration: cono0430/ shutterstock.com